Von der Erklärung zur Anpassung: Wie Unternehmen KI verständlich machen und laufend verbessern

Viele KI-Modelle glänzen im Test und scheitern anschließend im Alltag: Entscheidungen bleiben undurchsichtig, Modelle passen nicht mehr zu neuen Aufträgen, Materialien oder Maschinenzuständen. Unternehmen erleben KI dann als Black Box, der niemand so recht vertraut. Genau hier setzt das it’s OWL Projekt „ExplAIn“ an. Das Fraunhofer IEM entwickelt gemeinsam mit MIT Moderne Industrietechnik GmbH & Co. KG und Düspohl Maschinenbau GmbH ein vierstufiges Framework für vertrauenswürdige KI in der Produktion: „Safe Training“, „Safe Usage“, „Explainability“ und „Adaptability“. Ziel ist, Qualität zu steigern, Ausschuss zu senken und gleichzeitig KI-Systeme zu schaffen, die Fachkräfte verstehen und die sich an die Praxis anpassen. Im Mittelpunkt dieses Beitrags stehen die Stufen „Explainability“ (Erklärbarkeit) und „Adaptability“ (Anpassungsfähigkeit); zwei industrielle Use Cases zeigen, welchen direkten Nutzen Unternehmen daraus ziehen.

Im Use Case „Schweißanomalieerkennung“ von MIT Moderne Industrietechnik und Fraunhofer IEM geht es darum, Auffälligkeiten im Schweißprozess zu erkennen und für Fachleute transparent zu machen.

Die Projektpartner bereiten dafür Korrelationen zwischen Prozessgrößen wie Spannung, Strom und Drahtvorschub visuell auf. Auf einer Klassifikationskarte sehen Mitarbeitende, in welchen Bereichen des Prozessraums die KI Anomalien detektiert und wie empfindlich diese Entscheidungen reagieren.

Zum Einsatz kommt unter anderem der „Local Outlier Factor“. Dahinter steckt ein Verfahren, das jeden Datenpunkt mit seinen Nachbarn vergleicht und einen Ausreißerwert berechnet: Weicht ein Punkt stark von der Umgebung ab, stuft das System ihn als potenziell kritisch ein.

Mehr erfahren: Lösungsbaustein auf der it’s OWL Innovationsplattform

Sie möchten tiefer in das Thema einsteigen und die Ansätze aus ExplAIn im Detail nachvollziehen? Im Lösungsbaustein „Vertrauenswürdige KI durch Explainability und Adaptability“ auf der it’s OWL Innovationsplattform wird die Lösung aus dem Projekt noch ausführlicher beschrieben.Dort finden Sie eine vertiefte Darstellung der Methodik, der Bausteine und der industriellen Anwendungsbeispiele.

Zum Lösungsbaustein

Der Nutzen: Verantwortliche erkennen auf einen Blick, welche Prozesszustände unkritisch sind und wo die KI Probleme sieht. Das System bleibt keine abstrakte Berechnung, sondern liefert eine Landkarte seiner eigenen Entscheidungen.

Für die Stufe „Adaptability“ entwickelt das Projektteam eine zweistufige Human-in-the-loop-Strategie. „Human in the loop“ bedeutet: Menschen bleiben bewusst Teil der Entscheidungsschleife und geben Feedback, wenn die KI unsicher oder falsch liegt.

- Zuerst überwacht eine Wächterfunktion die laufenden Datenströme. Sie identifiziert neue Datenkonstellationen oder unplausible Muster, unterstützt durch physikalisch informierte Ansätze, also durch Vorwissen über das reale Verhalten des Schweißprozesses. Diese Daten hebt das System hervor und priorisiert sie für eine menschliche Bewertung.

- Im zweiten Schritt nutzt die KI dieses Feedback, um die Modelle iterativ nachzutrainieren. Anomalie-Schwellenwerte passen sich schrittweise an, ohne dass Fachkräfte jeden Parameter manuell verändern müssen.

So bleibt die Lösung robust und lernt gleichzeitig mit den realen Prozessbedingungen mit.

Rüstzeiten senken: Düspohl setzt auf KI-Assistenz

Düspohl Maschinenbau arbeitet gemeinsam mit dem Fraunhofer IEM im Use Case „RoboWrap“ daran, die Einrichtung von Profilummantelungsanlagen mit KI zu unterstützen. Ziel ist eine deutlich schnellere und stabilere Einstellung der Anlage, ohne dass das Bedienpersonal die Kontrolle verliert.

Die Partner setzen gradientenbasierte Verfahren ein und binden diese in eine grafische Benutzeroberfläche ein. Gradientenverfahren markieren, welche Eingangsinformationen, zum Beispiel Materialeigenschaften oder konkrete Prozessparameter, den größten Einfluss auf die Entscheidung der KI haben. Auf der Oberfläche sieht das Bedienpersonal somit nicht nur das Rüst-Ergebnis, sondern auch, welche Merkmale die Entscheidung geprägt haben.

Aus einer Black Box wird so ein Assistenzsystem, dessen Vorschläge plausibel, diskutierbar und korrigierbar sind. Ein weiterer Vorteil: Die Mehrdeutigkeit der Realität wird sichtbar. In der Praxis existieren oft mehrere gute Strategien für eine Einrichtung. Statt diese Vielfalt zu verstecken, macht die Visualisierung sie transparent. Das stärkt die fachliche Diskussion im Team und die Akzeptanz der KI.

Im Kontext der Stufe „Adaptability“ konzipieren Düspohl und Fraunhofer IEM ein Online-Learning-Konzept. Online-Learning bezeichnet Lernverfahren, bei denen das Modell laufend mit neuen Daten aktualisiert wird.

Ein Novelty-Check, also eine Neuartigkeitsprüfung, erkennt neue Produkte, Setups oder Strategiewechsel. Nur wirklich neue Informationen fließen in ein Batch-Training ein. Batch-Training bedeutet: Die KI trainiert mit einem „Paket“ von gesammelten Beispielen, statt jede Beobachtung einzeln zu verarbeiten. So bleibt das KI-System stabil und wächst gezielt an den Stellen, an denen sich die Realität ändert.

Der Mensch bleibt dabei die finale Instanz. Das Bedienpersonal bewertet die Rüstvorschläge der KI, und diese Rückmeldungen dienen als Lernsignal. Für Düspohl entsteht so ein Mehrwert: verkürzte Rüstzeiten, dauerhaft hohe Produktqualität, gesicherter Wissenstransfer trotz Personalwechsel und eine schrittweise, datengestützte Optimierung direkt beim Kunden.

Erklärbare KI: Entscheidungen sichtbar machen

Erklärbarkeit gehört zu den Grundpfeilern vertrauenswürdiger KI. Gemeint ist die Fähigkeit, Entscheidungen eines KI-Systems so aufzubereiten, dass Menschen sie nachvollziehen können. In der industriellen Praxis reicht es nicht, dass ein Modell im Durchschnitt „gut funktioniert“. Wer eine Anlage mit KI-Unterstützung betreibt, braucht Klarheit, warum das System eine Empfehlung als gut oder schlecht einstuft.

Die Stufe „Explainability“ liefert einen dreifachen Nutzen:

- Vertrauen: Anwenderinnen und Anwender sehen, welche Daten und Muster eine Empfehlung prägen.

- Sicherheit: Teams erkennen kritische Fehlentscheidungen schneller, können sie plausibilisieren und abstellen.

- Fairness und Compliance: Verzerrungen (Bias) werden sichtbar, und Vorgaben zur Transparenz und Nachvollziehbarkeit, etwa aus der EU-KI-Verordnung, lassen sich adressieren.

Bias bedeutet hier eine systematische Verzerrung in Daten oder Modell. Schlechte Datenverteilung, versteckte Korrelationen oder ungewollte Zusammenhänge können dazu führen, dass eine KI überrepräsentierte Muster verstärkt. Ohne Erklärungsschicht bleibt das oft unsichtbar. Mit geeigneten Methoden erkennen Fachleute solche Verzerrungen und schaffen damit die Voraussetzung für die Stufe „Adaptability“.

Welche Methoden ExplAIn hierfür nutzt, zeigt Abbildung 1. Dazu zählen die Analyse partieller Gradienten, Surrogatmodelle und schichtweise Ausgabenanalysen. Ziel aller Ansätze: aus einem schwer durchschaubaren Netz von Berechnungen verständliche Entscheidungsregeln machen.

Gradienten und Heatmaps: Clever-Hans-Effekte erkennen

Ein zentrales Werkzeug im Projekt sind Verfahren zur Analyse partieller Gradienten. Sie zeigen, welche Bereiche der Eingangsdaten für eine bestimmte Entscheidung eines neuronalen Netzes besonders wichtig waren. Ein neuronales Netz ist hier ein statistisches Modell, das sich an der Funktionsweise des Gehirns orientiert. In vielen Lagen – sogenannten Schichten – verarbeitet es Daten und erkennt Muster.

In der Praxis lassen sich Gradientenanalysen als Heatmap visualisieren. Eine Heatmap ist eine farbige Darstellung, in der warme Farben Bereiche mit hoher Bedeutung markieren.

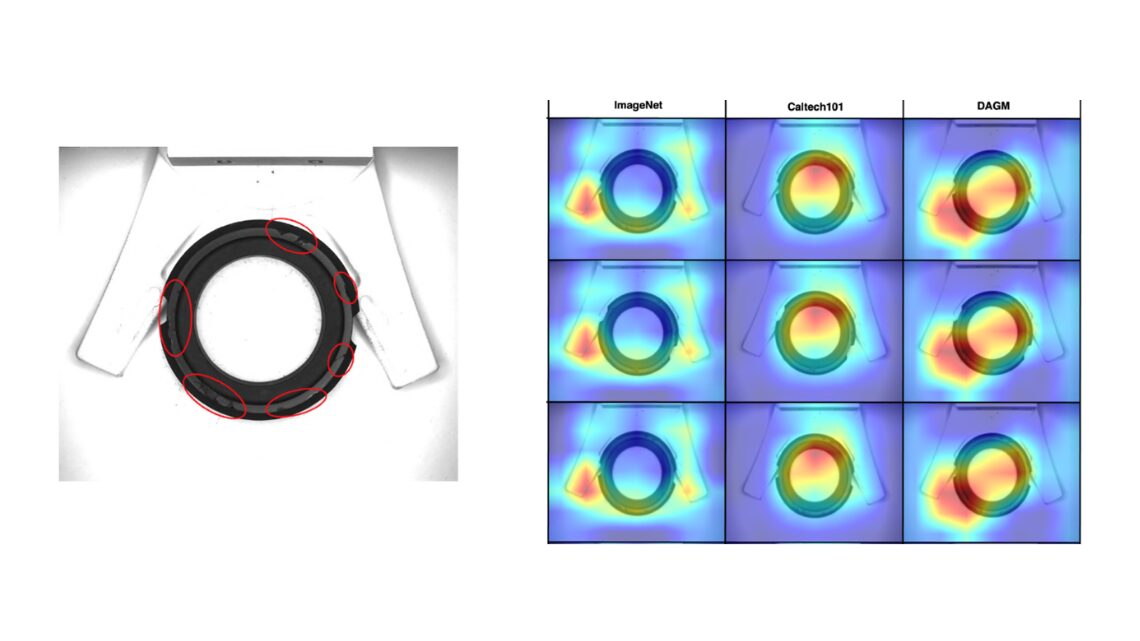

Abbildung 2 macht das Prinzip greifbar. In dem Beispiel soll ein Dichtring vor der Zuführung im Montageprozess automatisiert auf Fehlstellen geprüft werden. Ein Netz aus der „ImageNet“-Familie liefert auf Testdaten zunächst die besten Klassifikationsergebnisse. ImageNet ist eine bekannte Bilddatenbank, auf der viele Modelle für die Bildverarbeitung trainiert werden, etwa sogenannte Convolutional Neural Networks (CNNs). Diese Netzarchitektur eignet sich besonders gut für Bilder.

Die Heatmaps in Abbildung 2 zeigen jedoch, dass das Modell seine Entscheidungen nicht am Dichtring selbst festmacht, sondern an Reflektionen auf der Klemme. Die KI trifft also richtige Entscheidungen aus falschen Gründen. Dieses Phänomen ist als „Clever-Hans-Effekt“ bekannt, in Anlehnung an ein Pferd, das scheinbar rechnen konnte, in Wahrheit aber nur auf die Reaktionen seines Besitzers reagierte.

In einem produktiven Einsatz würde ein solches System versagen und das Vertrauen der Mitarbeitenden in KI-Lösungen deutlich schwächen. Durch die Stufe „Explainability“ wird dieses Verhalten sichtbar. Teams können auf dieser Basis die Datengrundlage verbessern, die Modellstruktur anpassen oder das Einsatzszenario prüfen. Aus einer intransparenten Black Box entsteht ein System, dessen Regeln sich nachvollziehen und gezielt verändern lassen.

Surrogatmodelle: komplexe Modelle verständlich machen

Ein weiterer Baustein der Erklärbarkeit im Projekt sind Surrogatmodelle. Ein Surrogatmodell ist ein bewusst einfach gehaltenes Ersatzmodell, etwa ein Entscheidungsbaum. Es ergänzt ein komplexes Modell wie ein Deep Neural Network und bildet dessen Verhalten in vereinfachter Form ab.

Deep Neural Networks bestehen aus vielen hintereinandergeschalteten Schichten künstlicher Neuronen und können sehr komplexe Zusammenhänge abbilden. Sie sind leistungsfähig, aber schwer zu interpretieren.

Indem ExplAIn ein erklärbares Surrogatmodell neben ein komplexes Netz stellt, lassen sich Entscheidungen besser nachvollziehen. Das Bedien- und Instandhaltungspersonal braucht keine komplizierten Formeln, sondern klare visuelle Hinweise, welche Datenbereiche und Parameter das Ergebnis prägen und wo Unsicherheit besteht.

Adaptierbare KI: Systeme lernen aus Feedback

Auf die Erklärbarkeit folgt die Stufe „Adaptability“. Sie baut direkt auf der Transparenz der vorherigen Stufe auf. Erst wenn klar ist, wie ein System zu seinen Entscheidungen gelangt, können Fachleute Schwachstellen erkennen und gezielt adressieren.

Adaptierbarkeit beschreibt die Fähigkeit einer KI, ihr Verhalten kontrolliert an neue Daten, Produkte, Maschinenzustände und Strategien anzupassen. In industriellen Umgebungen ändern sich Auftragsmix, Materialqualitäten, Prozessketten und Anlagenzustände laufend. Ein statisches Modell gerät hier schnell an Grenzen.

Abbildung 3 fasst zentrale Bausteine der ExplAIn-Methodik zur Adaptierbarkeit zusammen. Sie zeigt unter anderem einen „Bias-building Digital Twin“, bei dem ein digitaler Zwilling – ein virtuelles Abbild der Anlage – genutzt wird, um gezielt verzerrte Situationen zu erzeugen und die KI darauf zu testen. Ergänzend kommen Human-in-the-loop-Ansätze und KI-basiertes Finetuning zum Einsatz.

Im Kern steht immer eine Rückkopplung zwischen System und Mensch: Die KI liefert Ausgaben, das Personal bewertet sie, und dieses Feedback fließt wieder in das System ein.

Die Stufe „Adaptability“ umfasst im Projekt drei Ansätze:

- Human-in-the-loop: Menschen geben Feedback, wenn die KI falsch oder unsicher liegt. Sie liefern Labels, Korrekturen oder Gewichtungen. Erfahrungswissen aus der Produktion landet so direkt im System.

- Daten- und Modellpflege: Novelty-Checks und Algorithmen zur Drift-Erkennung überblicken, ob neue Datenmuster auftreten oder Grenzwerte nicht mehr passen. Drift-Erkennung meint Verfahren, die schleichende Veränderungen in Datenverteilungen sichtbar machen. Das System schlägt Anpassungen vor, bevor sich Qualitätsverluste einschleichen.

- Lernstrategien: Active Learning fragt gezielt neue Daten für unsichere Bereiche ab. Die KI „weiß“, wo sie wenig Beispiele hat, und fordert dort zusätzliche Daten an. Online- und Batch-Training halten Modelle aktuell, ohne ihre Stabilität zu gefährden.

Neben den technischen Verfahren berücksichtigt ExplAIn bewusst sozio-technische Faktoren. Die Akzeptanz der betroffenen Mitarbeitenden entscheidet darüber, ob ein adaptives System im Alltag wirklich lernt. Schulungen, verständliche Oberflächen und klare Zuständigkeiten für Feedback und Freigaben gehören deshalb fest zur Methodik.

Fazit und Ausblick: ExplAIn als Werkzeugkasten für vertrauenswürdige KI

Die Stufen „Explainability“ und „Adaptability“ bilden im Projekt ExplAIn ein Gerüst für vertrauenswürdige KI in der Industrie. Erklärbarkeit schafft Transparenz, deckt fehlerhafte oder unplausible Muster auf und liefert die Grundlage für gezielte Anpassungen. Adaptierbarkeit sorgt dafür, dass KI-Systeme auch unter veränderten Bedingungen robust, aktuell und kundenspezifisch bleiben und systematisch vom Wissen der Fachkräfte profitieren.

Die Projektpartner verstetigen die validierten Bausteine nach Projektende in ihren Unternehmen und bauen sie weiter aus. Am Fraunhofer IEM zeigt ein Demonstrator die Ansätze und Learnings aus den industriellen Use Cases in konzentrierter Form. Über die it’s OWL Innovationsplattform und den Lösungsbaustein „Vertrauenswürdige KI durch Explainability und Adaptability“ stehen zusätzliche Ergebnisse für interessierte Unternehmen bereit.

ExplAIn versteht KI bewusst nicht als Selbstzweck, sondern als Werkzeug im Werkzeugkasten. Die Methodik der hybriden Modellbildung kombiniert Expertenmodelle und -verfahren mit datengetriebenen KI-Systemen. Das stufenweise Vorgehen unterstützt Verantwortliche bei der Entscheidung, ob und in welcher Form ein KI-Verfahren für eine konkrete Aufgabenstellung sinnvoll ist oder ob andere Lösungsansätze besser passen.

Damit adressiert ExplAIn eine zentrale Frage aus der industriellen Praxis: Wie gelingt der Sprung von leistungsfähiger, aber intransparenter KI hin zu lernfähigen Assistenzsystemen, die Fachkräfte stärken, messbare Verbesserungen liefern und Vertrauen im Betrieb aufbauen?